Datasets EMPATIA

- Portada

- Investigación

- Proyectos

- EMPATIA-CM

- Datasets EMPATIA

DATASETS

Siguiendo la línea de investigación propuesta en el proyecto EMPATIA-CM, que tiene como objetivo comprender de manera general las reacciones de las Víctimas de Violencia de Género ante situaciones de peligro y generar mecanismos de detección y protección automática, se presenta la base de datos UC3M4Safety https://edatos.consorciomadrono.es/dataverse/empatia en la que se recogen diversos datasets divididos en dos bloques principales según el origen, periodo de la investigación y tipología de datos que contienen.

[1] Etiquetado emocional de un conjunto de estímulos audiovisuales

En este bloque se presentan los resultados obtenidos durante el año 2020 en el que, mediante el análisis del etiquetado reportado por 1520 participantes (929 mujeres, 591 hombres) con edades comprendidas entre 18-78 años (promedio-38.27, SD-14.47), se realiza la selección de un conjunto de estímulos audiovisuales.

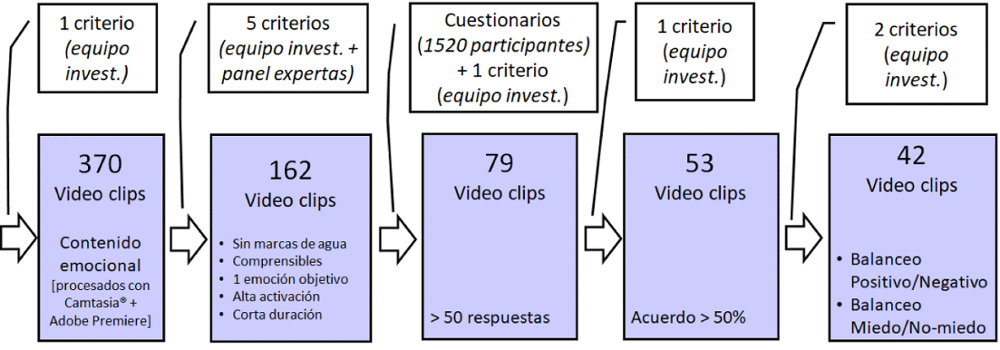

Esta selección se realiza en cinco pasos, como se muestra en la Figura. En cada paso se han refinado los estímulos seleccionados para asegurar la calidad requerida para los fines de la investigación. https://edatos.consorciomadrono.es/dataverse/empatia

Se partió de un conjunto de 370 video clips seleccionados por el equipo investigador, con el único criterio de presentar un alto contenido emocional. Posteriormente, con el apoyo de un panel de expertas en protección a Víctimas de Violencia de Género, este conjunto de video clips se redujo a 162, aplicando cinco criterios de calidad (sin marcas de agua, comprensible, una única emoción principal, provocando reacciones de gran activación y siendo escenas de corta duración). Los 162 estímulos se presentaron, en formato online, a un conjunto de 1520 personas voluntarias (todos los géneros, edades entre 16 y 78 años) que etiquetaron las emociones experimentadas durante su visualización. En un tercer filtro, se eligieron los 79 vídeos que habían tenido más de 50 respuestas. Posteriormente, de estos se seleccionaron los 53 que obtuvieron más de un 50% de acuerdo. Finalmente se llegó a un conjunto de 42 vídeo clips que cumplían con un balance equilibrado entre emociones negativas y positivas y, lo más importante para poder entrenar futuros sistemas inteligentes, con un balance equilibrado entre la emoción de miedo y el resto.

Toda la metodología seguida y resultados se puede encontrar de forma más detallada en los artículos en revista científica referencia 1 y referencia 6, y en los datasets:

01_dataset_list_video / UC3M4Safety Database - List of Audiovisual Stimuli (Video): Descripción (título, duración, tipo de vídeo, descripción de la escena) de los 79 videos usados en el experimento

02_dataset_labels / UC3M4Safety Database - List of Audiovisual Stimuli: Etiquetado e indicadores emocionales reportados por las y los participantes según género y grupo de edad.

[2] WEMAC (Women and Emotion Multi-modal Affective Computing Dataset)

En este bloque se presentan las variables físicas y fisiológicas ante la elicitación de diferentes emociones recogidas durante la realización de experimentos de laboratorio. El conjunto final de participantes incluye 100 mujeres voluntarias de entre 20 y 77 años (con un promedio de 39.92 y una desviación estándar de 14.26)

El reclutamiento se llevó a cabo a través de convocatorias privadas, método “bola de nieve”, o públicas, en las redes sociales del equipo de investigación, siendo necesaria una selección previa para asegurar que cumplían con los requisitos mínimos (no VVG, buena salud, sin vértigo, mareos, estrés postraumático). Previamente, se proporcionó una descripción del experimento, y se tuvo que firmar una aceptación antes de la inclusión en el grupo de voluntarias. En todos los casos, ela voluntarioa debería haber aceptado, libre y conscientemente, participar en este experimento. Esta aceptación está incluida en el Consentimiento Informado para la Prueba y Tratamiento de Datos (03_QuestForm_WEMAC_U4S.pdf).

Las voluntarias que participaron, visualizaron un total de 14 vídeos (seleccionados del conjunto de 42 de UC3M4Safety_stimuli, sección [1]) en un entorno de Realidad Virtual y etiquetaron las respuestas emocionales experimentadas a través de un conjunto de pantallas, previamente explicadas a través de un documento y una demostración práctica (04_DS_Labels_WEMAC_U4S.csv). Para visualizar un solo estímulo, las participantes pasaron por 4 pasos: una pantalla neutral inicial, visualización de videoclip, preguntas de etiquetado y una escena final de recuperación o descanso. La duración total se estimó entre 90 y 120 minutos.

Mientras que las voluntarias participaban, se monitorizaron diferentes variables fisiológicas a través de un equipo homologado “biosignalplux” (05_DS_Physio_WEMAC_U4S.mat). Estas variables son:

Actividad electrodérmica, conectada a la muñeca no dominante de la participante, mediante electrodos biomédicos.

Temperatura de la piel, conectada al brazo no dominante de la participante por una pieza metálica sujeta con cinta adhesiva para uso médico.

Frecuencia cardíaca, medida por una pinza de fotopletismografía médica ubicada en el dedo índice de la mano no dominante de la participante.

Las grabaciones de audio (06_DS_AudioFeat_WEMAC_U4S.zip) se almacenaban después de cada visualización audiovisual. Esta grabación se realiza a través del micrófono que ha incorporado el Casco de Realidad Virtual.

Se puede encontrar más información acerca de la metodología y resultados en los artículos en revista científica con referencia 3 y referencia 4, y en los datasets:

03_DS_Quest_WEMAC_U4S / UC3M4Safety Database - WEMAC: Biopsychosocial questionnaire and informed consent: Respuestas del cuestionario biopsicosocial recogidas durante en el experimento de laboratorio.

04_DS_Labels_WEMAC_U4S / UC3M4Safety Database - WEMAC: Emotional labelling: Etiquetados emocional reportado por los participantes después de la visualización de cada uno de los estímulos durante el experimento de laboratorio.

05_DS_Physio_WEMAC_U4S / UC3M4Safety Database - WEMAC: Physiological signals: Señales fisiológicas monitorizadas durante el experimento de laboratorio.

06_DS_AudioFeat_WEMAC_U4S / UC3M4Safety Database - WEMAC: Audio features: Características extraídas de las grabaciones de audio recogidas durante el experimento de laboratorio.

El uso del conjunto de datos WEMAC está bajo una licencia Creative Commons Attribution 4.0 International License (CC-BY-4.0). Los datos están cifrados. Las instrucciones para descifrar dichos datos se proporcionan después de completar un formulario EULA (End User License Agreement), que debe firmarse y enviarse por correo electrónico al equipo de UC3M4Safety (uc3m4safety@uc3m.es).

Enlace a EULA (End User Licence Agreement)

Todo este conjunto de datos se pone a disposición del público en el Repositorio de Datos del Consorcio Madroño y animamos a otros equipos de investigación a que lo utilicen para probar sus propios métodos de predicción y análisis de los estados afectivos. La base de datos puede utilizarse para muchos otros fines de protección de grupos vulnerables.

Los siguientes artículos profundizan sobre las cuestiones anteriores:

- Blanco-Ruiz, M., Sainz-de-Baranda, C., Gutiérrez-Martín, L., Romero-Perales, E., & López-Ongil, C. (2020). Emotion elicitation under audiovisual stimuli reception: Should artificial intelligence consider the gender perspective?. International Journal of Environmental Research and Public Health, 17(22), 8534. https://doi.org/10.3390/ijerph1722853

- Miranda, J. A., Canabal, M. F., Gutiérrez-Martín, L., Lanza-Gutiérrez, J. M., & López-Ongil, C. (2022). Edge computing design space exploration for heart rate monitoring. Integration, 84, 171-179. https://doi.org/10.1016/j.vlsi.2022.02.003. https://www.sciencedirect.com/science/article/pii/S0167926022000177

- Miranda, J. A., Rituerto-González, E., Gutiérrez-Martín, L., Luis-Mingueza, C., Canabal, M. F., Ramírez Bárcenas, A., Lanza-Gutiérrez, J. M., Peláez-Moreno, C., López-Ongil, C. (2022). WEMAC: Women and Emotion Multi-modal Affective Computing dataset. arXiv. doi.org/10.48550/arXiv.2203.00456 - http://arxiv.org/abs/2203.00456

- Miranda, J. A., Rituerto-González, E., Luis-Mingueza, C., Canabal, M. F., Bárcenas, A. R., Lanza-Gutiérrez, J. M., & López-Ongil, C. (2022). Bindi: affective internet of things to combat gender-based violence. IEEE Internet of Things Journal, 9(21), 21174-21193. https://doi.org/10.1109/jiot.2022.3177256

- Sainz-de-Baranda Andujar, C., Gutiérrez-Martín, L., Miranda-Calero, J. Á., Blanco-Ruiz, M., & López-Ongil, C. (2022). Gender biases in the training methods of affective computing: Redesign and validation of the Self-Assessment Manikin in measuring emotions via audiovisual clips. Frontiers in Psychology, 13, 955530. https://doi.org/10.3389/fpsyg.2022.955530

- Sainz de Baranda Andújar, C., Blanco Ruiz, M., Miranda Calero, J. Á., Gutiérrez Martín, L., Canabal Benito, M. F., San Segundo, R., & López Ongil, C. (2021). Gender and Social Perspective in STEM Training: Artificial Intelligence Systems for Emotion Detection. https://doi.org/10.24197/st.Extra_1.2021.83-115

Agradecimientos

Queremos agradecer todo el personal del equipo de investigación UC3M4Safety su colaboración en la difusión de los cuestionarios online y en la captación de voluntarias para los experimentos con los sensores de medición de las variables fisiológicas. Además, la realización de las pruebas de laboratorio ha supuesto un esfuerzo importante que ha realizado el equipo con un grado de implicación y de rigor muy destacables.

Queremos agradecer también la participación a las 1520 personas voluntarias que completaron los cuestionarios online para la selección de los estímulos audiovisuales más apropiados que forman parte de la sección [1] de la base de datos UC3M4Safety. Y especialmente a las 144 voluntarias que participaron en los experimentos de laboratorio con realidad virtual.

FINANCIACIÓN

Este proyecto está financiado por la Comunidad de Madrid, Consejería de Ciencia, Universidades e Innovación,

Programa de proyectos sinérgicos de I+D en nuevas y emergentes áreas científicas en la frontera de la ciencia y de naturaleza interdisciplinar, cofinanciada con los Programas Operativos del Fondo Social Europeo y del Fondo Europeo de Desarrollo Regional, 2014-2020, de la Comunidad de Madrid (EMPATÍA-CM, Ref: Y2018/TCS-5046)